Блог администратора

Новости и статьи по созданию, раскрутке, продвижению, оптимизации сайтов в поисковых системах, а так же полезные советы и раскрутка в социальных сетях.

By accepting you will be accessing a service provided by a third-party external to https://krutim-all.ru/

Как настроить Robots.txt

Для чего нужен файл robots.txt

Robots.txt файл который лежит в корне сайта и указывает поисковым роботам какие разделы сайта запрещены к индексации. Полное описание что такое robot.txt вы уже узнали из нашей статьи и по этому мы перейдем к его настройке для того, что бы Вы могли понимать как это делается и для чего это нужно.

Настройка файла robots.txt

В первую очередь перед открытием сайта необходимо произвести его seo оптимизацию и одним пунктом из оптимизации является настройка файла robots.txt. Файл robots.txt содержит определенные правила:

- Название файла обязательно должно быть с маленькой буквы.

- Оператор обозначается как "User-agent" и ставится в самом начале при создании файла. "User-agent" дает Вам возможность указать правила для конкретной поисковой системы и именно после обозначения "User-agent" со следующей строчки начинают писаться правила.

- Когда Вы указываете правила для всех поисковых систем Вам необходимо прописать в первой строчке файла "User-agent: *" звездочка в данном случае обозначает, что правила будут создаваться для всех поисковых систем.

- Далее на следующей строке после оператора "User-agent" должны идти операторы "Disallow" которые запрещают к индексации те или иные разделы, страницы и т.п. Пробелов между "User-agent" и "Disallow" быть не должно так как пробел означает конец правил.

- Оператор "Disallow" заполняется следующим образом "Disallow: /каталог который нужно запретить к индексации" если Вы делаете сайт сразу на хостинге и в момент разработки Вам нужно полностью запретить его к индексации просто укажите "Disallow: /" и Ваш сайт не будет индексировать поисковыми системами так как слеш определяет корень сайта и соответственно индексация будет закрыта для всего сайта.

- Обратите внимание, что для поисковой системы yandex следует указать свой "User-agent" и Выглядеть он должен вот так "User-agent: Yandex" и после него так же указываем "Disallow: /каталог который нужно запретить к индексации"

- Так же в robots.txt указывается основной хост для Вашего сайта. Как мы уже описывали в статье при выборе основного домена сайта и зеркала сайта Вам нужно определиться с www будет Ваш основной домен или без. Хост прописывается после всех операторов в низу файла таким образом "Host: krutim-all.ru" данный Вариант когда выбран основной домен сайта без www

- Сразу посте строчки "Host: krutim-all.ru" указывается адрес карты сайта, что бы поисковые роботы быстрее индексировали Ваш сайт. Адрес карты сайта указывается таким образом "Sitemap: http://krutim-all.ru/sitemap.xml"

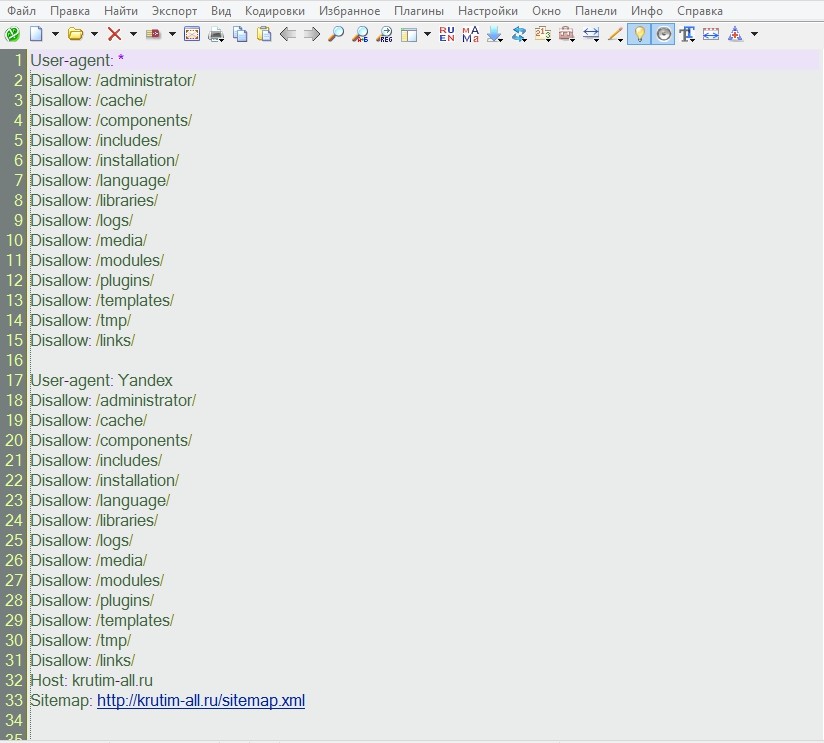

Пример правильного файла robot.txt:

{jllikelock}

User-agent: *

Disallow: /administrator/

Disallow: /cache/

Disallow: /components/

Disallow: /includes/

Disallow: /installation/

Disallow: /language/

Disallow: /libraries/

Disallow: /logs/

Disallow: /media/

Disallow: /modules/

Disallow: /plugins/

Disallow: /templates/

Disallow: /tmp/

Disallow: /links/

User-agent: Yandex

Disallow: /administrator/

Disallow: /cache/

Disallow: /components/

Disallow: /includes/

Disallow: /installation/

Disallow: /language/

Disallow: /libraries/

Disallow: /logs/

Disallow: /media/

Disallow: /modules/

Disallow: /plugins/

Disallow: /templates/

Disallow: /tmp/

Disallow: /links/

Host: krutim-all.ru

Sitemap: http://krutim-all.ru/sitemap.xml

{/jllikelock}

Обратите внимание, что данный текст пример правильной настройки и это не значит что он подойдет для Вашего сайта. В примере вы можете рассмотреть как правильно заполняется данный файл, где нужны пробелы и пустые строки и т.п. а так же можете скачать данный файл что бы редактировать уже по готовому. Настройки Вашего собственного файла robots.txt Вы легко можете определить самостоятельно просмотрев весь сайт и закрыть к индексации ненужные страницы и каталоги. Для примера Вы можете прочитать нашу статью "Дубли страниц сайта" и понять почему нужно закрывать к индексации страницы сайта и какие из них нужно закрывать.

Операторs User-Agent

Имена роботов поисковых систем:

- Нужная поисковая система Параметр для дерективы User-Agent

- Все поисковые системы User-agent: *

- Яндекс User-agent: Yandex

- Яндекс.Блоги User-agent: Yandex.Blog

- Google User-agent: GoogleBot

- mail.ru User-agent: Mail.Ru

- rambler User-agent: StackRambler

- Aport User-agent: Aport

- Yahoo User-agent: Slurp

- Alexa User-agent: Ia_archiver

Если Вам необходима индексация всеми поисковыми системами просто укажите «*»:

Операторы устанавливаемые после User-agent

- Disallow — Запрещает индексировать каталог, файл или весь сайт.

- Allow - Обратное Disallow, разрешает индексировать указанные разделы сайта. Хотя он необязателен так как все, что Вы не запретили будет проиндексировано

- Host -Указывает основной домен сайта.

- Sitemap - Указывает адрес карты сайта (помогает для быстрой индексации сайта.

Спецсимволы * и $

С помощью специальных символов можно использовать регулярные выражения.

Символ * означает любую последовательность (так же пустую).

Символ $ ставиться для отмены символа *, идущего по умолчанию.

Запрещаем к индексации на сайте файлы с расширением .rar:

User-Agent: *

Disallow: *.rar$

Теперь запрещаем к индексации картинки форматов .png и .ico в разделе /katalog, и страницу /files/:

User-Agent: *

Disallow: /katalog*.png

Disallow: /katalog*.ico

Disallow: /files/$

Дерективы будут работать для всех поисковых роботов. Если, нужно запретить к индексации картинки с сайта роботом Яндекса и разрешить индексировать текст, то в этом случае нужно для отдельных поисковых роботов одной поисковой системы писать свои правила.

На этом закончим статью и теперь Вы самостоятельно сможете настроить файл robots.txt, а если у Вас остались вопросы или Вы в замешательстве, что закрывать, а что не нужно напишите нам и мы с радостью поможем Вам абсолютно бесплатно!

Помните, что грамотная настройка файла robots.txt напрямую влияет на последующие продвижение сайта.